Google представила Gemini 2.5 Flash — быструю и дешёвую ИИ-модель

На конференции Google Cloud Next компания официально представила Gemini 2.5 Flash — усовершенствованную и оптимизированную версию своей ИИ-модели, способную работать быстрее, дешевле и с более точным управлением вычислительными ресурсами. Это очередной шаг Google в сторону коммерчески жизнеспособного генеративного ИИ после громкой премьеры экспериментальной версии Gemini 2.5 Pro в прошлом месяце.

Теперь Google переходит от экспериментов к реальному внедрению моделей нового поколения в экосистему своих продуктов: от платформы для разработчиков Vertex AI до конечных пользователей в приложении Gemini.

Что такое Gemini 2.5 Flash и зачем он нужен

Gemini 2.5 Flash основан на том же коде, что и 2.5 Pro, но оптимизирован для более лёгких задач. Эта версия обеспечивает быстрые отклики на простые запросы, потребляя при этом меньше ресурсов. Такой подход снижает стоимость использования ИИ — как для Google, так и для клиентов.

Хотя Flash пока недоступен в пользовательском приложении Gemini, он уже внедряется в Vertex AI — облачную платформу Google для корпоративных и разработческих решений. Flash-модель в первую очередь ориентирована на автоматизацию, чат-ботов, аналитические ассистенты и другие сценарии, где важны скорость и экономичность.

«Динамическое мышление» стало управляемым

Одной из ключевых особенностей Gemini 2.5 стало внедрение технологии «динамического мышления» (dynamic thinking) — модели сами определяют, сколько «мысленных усилий» вложить в решение в зависимости от сложности запроса. В версии Flash эта функция стала более гибкой и контролируемой.

Теперь разработчики получают доступ к настройке «бюджета мышления» — можно задать, насколько глубоко модель должна анализировать запрос, тем самым балансируя между скоростью, точностью и стоимостью отклика. Это особенно важно в коммерческом использовании, где каждая миллисекунда и каждый цент имеют значение.

Также в ближайшие недели Google добавит в Vertex AI контекстное кеширование и управляемую донастройку моделей, что сделает их ещё более адаптивными под конкретные задачи.

Deep Research теперь работает на Gemini 2.5 Pro

Пока Flash выходит на рынок, старшая модель Gemini 2.5 Pro получила новое назначение — теперь она питает инструмент Deep Research, который ранее работал на версии 2.0. Deep Research позволяет пользователю задавать тему и получать развернутый, сгенерированный отчёт, собранный из релевантных источников в интернете.

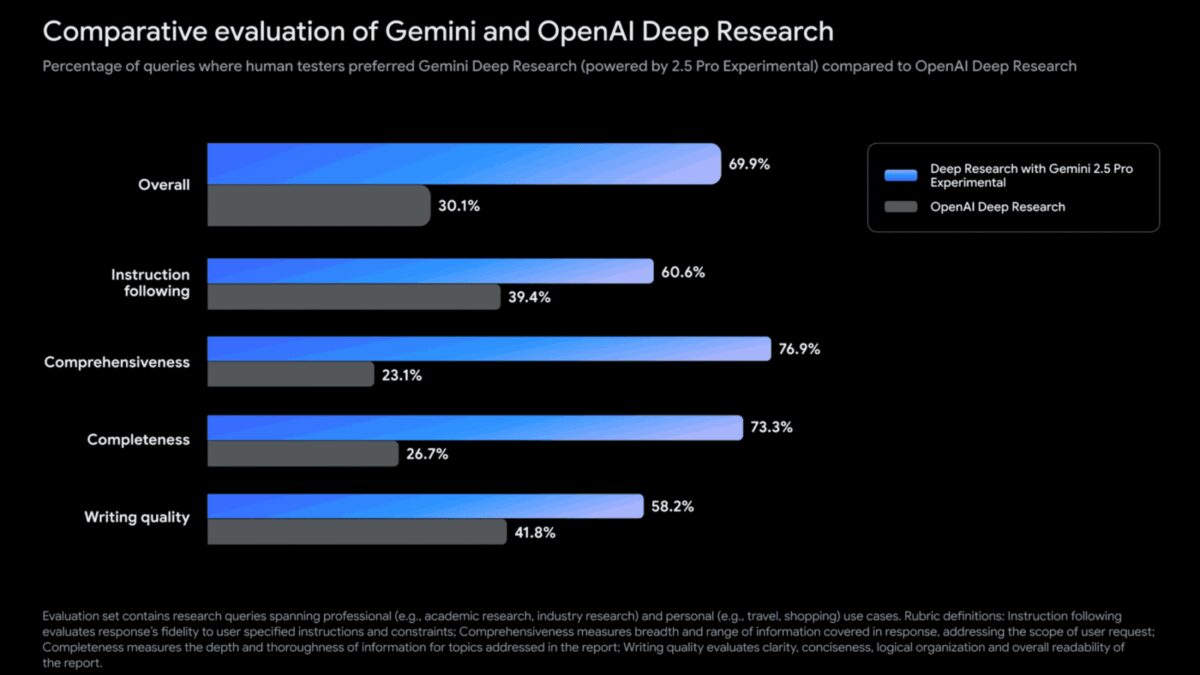

С переходом на Gemini 2.5 Pro качество и точность ответов значительно выросли. По словам Google, в пользовательских тестах отчёты от Gemini 2.5 Pro получают более чем в два раза больше положительных оценок, чем аналогичные от моделей OpenAI.

Правда, доступ к этой версии Deep Research ограничен: полные функции доступны только подписчикам Gemini Advanced, тогда как бесплатные пользователи получают урезанную версию.

К чему всё это ведёт

Серия обновлений Gemini 2.5 сигнализирует о начале нового этапа — внедрение ИИ, способного работать эффективно и экономично в реальных задачах. До сих пор генеративный ИИ был дорогим удовольствием, но теперь Google начинает снижать издержки с помощью более лёгких моделей и новых TPU-процессоров.

Переход всех продуктов Gemini на ветку 2.5 — лишь вопрос времени. С таким подходом Google делает ставку не на абстрактные бенчмарки, а на практичность, управляемость и бизнес-применимость.