Xiaomi представила свой первый открытый ИИ — MiMo-7B

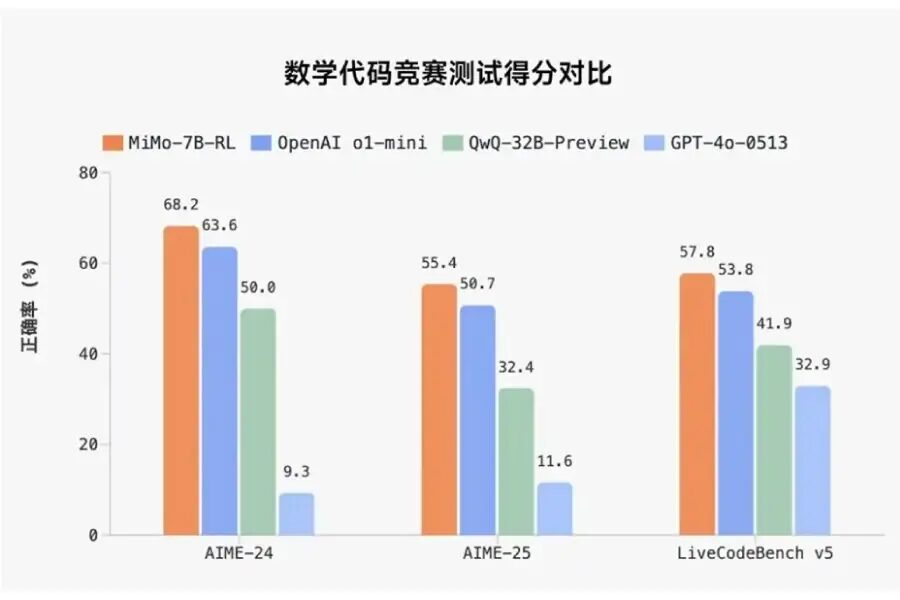

Компания Xiaomi официально вошла в сферу больших языковых моделей (LLM), представив MiMo-7B — первую публичную open-source модель, созданную новой командой Big Model Core Team. Модель ориентирована на задачи с высокой когнитивной нагрузкой, такие как математическое рассуждение и генерация кода. По заявлениям компании, MiMo-7B уже превосходит решения от OpenAI и Alibaba в этих областях.

Модель с акцентом на эффективность

MiMo-7B — это языковая модель с 7 миллиардами параметров. Несмотря на относительно компактный масштаб, Xiaomi утверждает, что она показывает сравнимые результаты с более крупными системами вроде OpenAI o1-mini и Alibaba Qwen-32B-Preview. Все три модели заточены под интеллектуальные задачи, но MiMo-7B выделяется эффективностью.

В основе — плотная предобучающая выборка: 200 миллиардов «токенов рассуждения» и в общей сложности 25 триллионов токенов за три фазы обучения. Вместо стандартного предсказания следующего токена Xiaomi использует множественное предсказание токенов, что, по их словам, сокращает время отклика модели без потери качества вывода.

Революции в обучении и инфраструктуре

На этапе пост-обучения используется комбинация методов обучения с подкреплением и внутренних оптимизаций. Xiaomi внедрила собственный алгоритм Test Difficulty Driven Reward, чтобы решить проблему слабых сигналов награды при решении сложных задач. Также применена техника Easy Data Re-Sampling, стабилизирующая обучение.

С точки зрения инфраструктуры, компания разработала систему Seamless Rollout для сокращения времени простоя GPU в процессе обучения и валидации. В результате, по внутренним данным Xiaomi, скорость обучения выросла в 2,29 раза, а производительность на этапе валидации — почти в 2 раза.

Эта система также поддерживает стратегии инференса, включая предсказание нескольких токенов в среде vLLM.

MiMo-7B: четыре версии и открытый доступ

Модель доступна в четырёх версиях:

- Base — чисто предобученная модель

- SFT — вариант, дообученный на размеченных данных

- RL-Zero — RL-модель, обученная с нуля

- RL — улучшенный RL-вариант на базе SFT с максимальной точностью

Согласно внутренним тестам Xiaomi, версия MiMo-7B-RL достигает 95,8% на бенчмарке MATH-500 и более 68% на датасете AIME 2024. В коде модель набирает 57,8% на LiveCodeBench v5 и около 50% на v6. В задачах общего знания (DROP, MMLU-Pro, GPQA) модель показывает результат в пределах 50–60%, что достойно для модели с 7B параметрами.

MiMo-7B уже доступна на Hugging Face под открытой лицензией. Документация и контрольные точки модели опубликованы на GitHub.