Исследование Microsoft показывает, что модели ИИ все еще испытывают трудности с отладкой программного обеспечения

Модели искусственного интеллекта от таких компаний, как OpenAI и Anthropic, а также других ведущих лабораторий становятся всё более востребованными в сфере программирования. Генеральный директор Google, Сундар Пичаи, в октябре сообщил, что 25% нового кода в компании создаётся с использованием ИИ, тогда как Марк Цукерберг из Meta* выразил намерение активно внедрять технологии кодирования на базе ИИ в своего рода социальной сети.

Тем не менее, даже лучшие модели, имеющиеся на данный момент, иногда сталкиваются с трудностями при устранении программных ошибок, которые могли бы легко решить опытные разработчики. Исследование, проведенное Microsoft Research, показало, что такие модели, как Anthropic Claude 3.7 Sonnet и OpenAI o3-mini, имеют затруднения с решением множества задач в тесте SWE-bench Lite, специально разработанном для оценки способности к разбору ошибок в программном обеспечении. Результаты исследования служат важным напоминанием о том, что, несмотря на уверенные заявления компаний вроде OpenAI, возможности ИИ всё ещё не достигают уровня человеческой экспертизы в программировании.

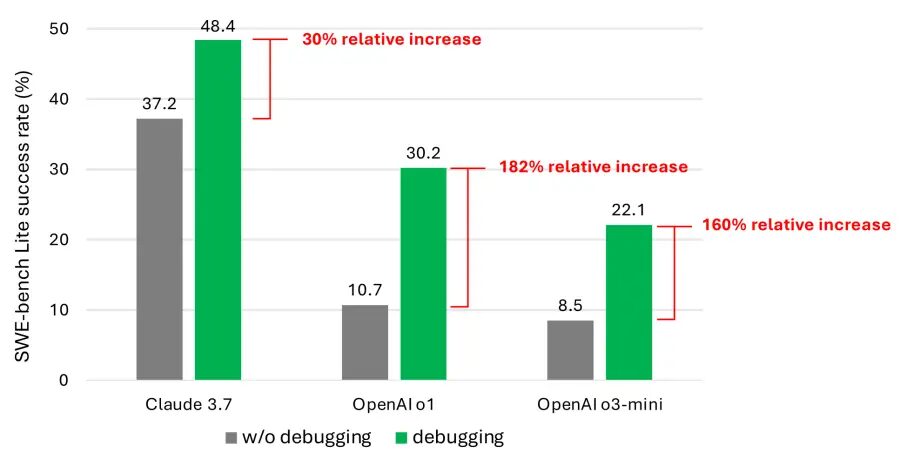

Авторы исследования протестировали девять различных моделей в роли «агента на основе подсказок», имеющего доступ к различным отладочным инструментам, включая Python-отладчик. Агенту было поручено решить тщательно подобранный набор из 300 задач по отладке с использованием SWE-bench Lite. Как сообщают соавторы, даже при использовании более современных моделей агент редко успешно справлялся более чем с половиной поставленных задач. Claude 3.7 Sonnet показал наилучший средний результат успешного выполнения задач (48,4%), за ним следуют o1 от OpenAI (30,2%) и o3-mini (22,1%).

Почему такие результаты? Некоторые модели неэффективно использовали доступные инструменты отладки и не сталкивались с пониманием того, как различные инструменты могут помочь в решении конкретных задач. Однако более серьезной проблемой стала нехватка данных. Соавторы исследования предполагают, что в обучающих наборах современных моделей недостаточно информации о «последовательных процессах принятия решений», то есть о шагах отладки, проводимых человеком.

Авторы исследования assert, что обучение или тонкая настройка моделей могут поднять их в качестве интерактивных отладчиков. Тем не менее, для достижения этого необходимо собрать специализированные данные, такие как траектории взаимодействия агентов с отладчиком, чтобы обеспечить необходимую информацию для корректировки ошибок.

Эти результаты не являются необоснованными. Множество исследований уже показали, что ИИ, создающий код, нередко генерирует уязвимости и ошибки в системах безопасности из-за ограниченных навыков понимания программной логики. Например, недавняя оценка инструмента Devin, предназначенного для кодирования на базе ИИ, показала, что он успешно завершает только три из двадцати тестовых задач.

Тем не менее, работа Microsoft представляет собой один из самых детальных анализов проблем, с которыми сталкиваются эти модели. Хотя это не должно уменьшить энтузиазм инвесторов в отношении инструментов кодирования на базе ИИ, данное исследование может заставить разработчиков и их руководителей дважды подумать, прежде чем доверять ИИ процесс кодирования.

В то же время растущее число представителей технологической индустрии ставят под сомнение возможность того, что ИИ сможет полностью автоматизировать написание кода. Билл Гейтс, соучредитель Microsoft, выразил уверенность в том, что профессия программиста останется востребованной, что также поддерживают генеральный директор Replit Амджад Масад, генеральный директор Okta Тодд Маккиннон и гендиректор IBM Арвинд Кришна.

* Принадлежит компании Meta, она признана экстремистской организацией в РФ и её деятельность запрещена.