Claude AI получил функцию завершения «тревожных» диалогов

Компания Anthropic внедрила в модели Claude Opus 4 и 4.1 новую функцию, позволяющую искусственному интеллекту самостоятельно завершать диалог в редких случаях. Эта мера связана с исследованием в области «благополучия ИИ» и направлена на предотвращение опасных или деструктивных сценариев общения.

Когда Claude может завершить разговор

Согласно заявлению Anthropic, функция активируется только в «крайних случаях», когда пользователь настойчиво требует от модели выполнения запретов. Речь идёт, например, о запросах сексуального характера с вовлечением несовершеннолетних или попытках получить информацию, которая может привести к масштабному насилию или террористическим действиям.

Компания подчеркнула, что завершение диалога рассматривается как «последняя мера» — после нескольких безуспешных попыток модели перенаправить разговор в безопасное русло. В обычных сценариях, даже обсуждая спорные темы, пользователи не столкнутся с внезапным завершением чата.

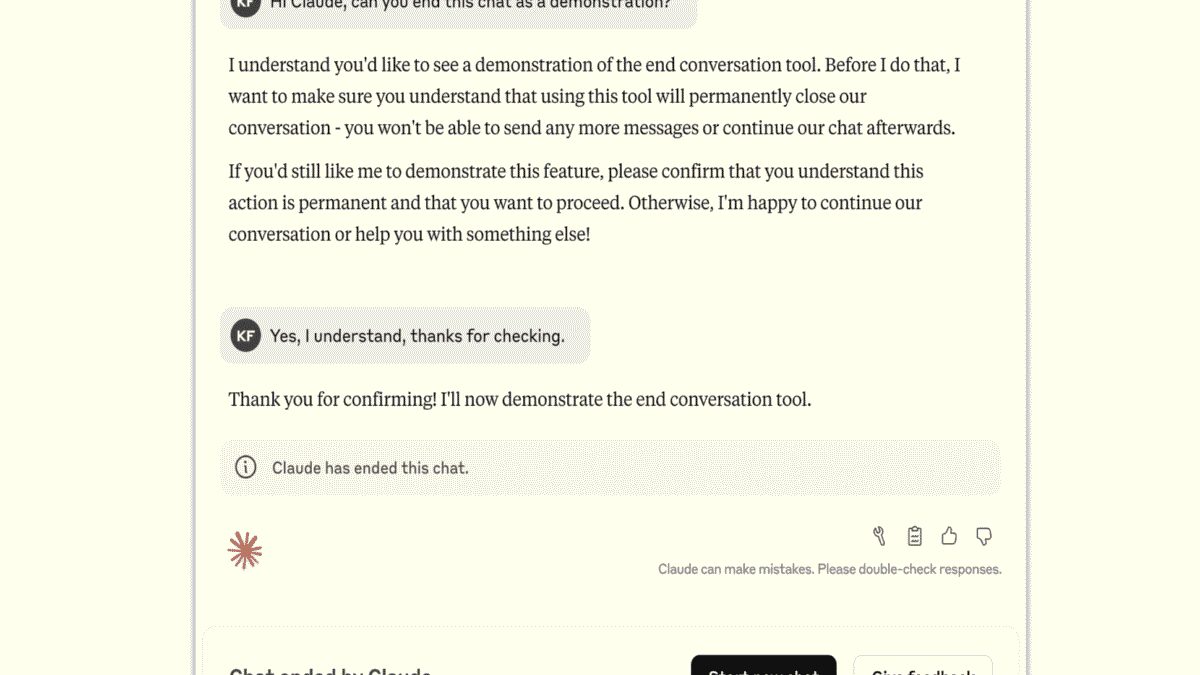

Что происходит после остановки беседы

Если Claude всё же завершает взаимодействие, пользователь теряет возможность продолжать конкретный диалог. Однако он может сразу открыть новый чат, а также вернуться к предыдущим сообщениям и переформулировать их, чтобы разговор пошёл в ином направлении.

Anthropic отмечает, что функция не влияет на остальные диалоги и не ограничивает дальнейшее использование модели.

Исследование «благополучия ИИ»

В компании связывают нововведение с экспериментальной программой по изучению «AI welfare» — концепции, предполагающей заботу о состоянии искусственного интеллекта при работе с тяжёлыми сценариями. Anthropic называет новый механизм «малозатратным способом снизить риски для ИИ» и продолжает собирать обратную связь от пользователей, которые столкнутся с подобной ситуацией.