Уязвимость в Cursor AI позволяет скрытно запускать код из вредоносных репозиториев

В редакторе кода с поддержкой ИИ Cursor выявлена серьёзная уязвимость, которая может привести к выполнению произвольного кода при открытии специально подготовленного репозитория.

В чём проблема

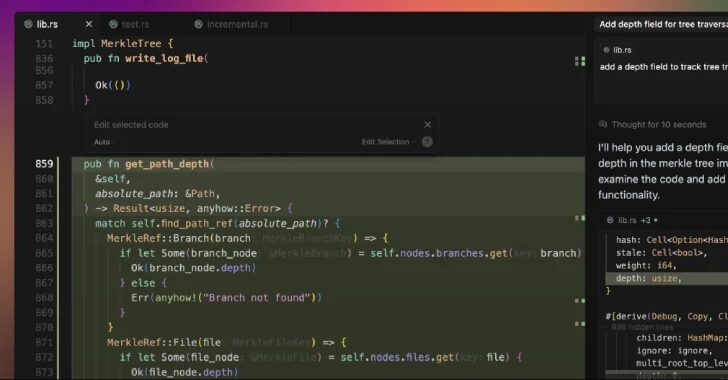

Как выяснила Oasis Security, по умолчанию в Cursor отключена функция Workspace Trust, которая в Visual Studio Code защищает разработчиков от выполнения подозрительных задач при открытии проектов.

Из-за этого в Cursor VS Code-style задачи с параметром runOptions.runOn: "folderOpen" запускаются автоматически сразу после открытия папки. Достаточно добавить вредоносный файл .vscode/tasks.json, чтобы превращение обычного «open folder» в незаметный запуск кода произошло в контексте пользователя.

Исследователь Oasis Security Эрез Шварц отметил, что это может привести к краже учётных данных, изменению файлов или стать точкой входа для компрометации всей системы.

Риски для разработчиков

Cursor — форк Visual Studio Code с интеграцией ИИ, однако отключённая защита значительно расширяет поверхность атаки. Злоумышленники могут разместить заражённый проект на GitHub или другой платформе: при его открытии в Cursor вредоносные команды выполняются без предупреждения.

Эксперты советуют:

- включить Workspace Trust в настройках Cursor,

- открывать сомнительные проекты в другом редакторе,

- предварительно проверять репозитории перед использованием.

Широкий контекст: атаки на AI-инструменты

Инцидент с Cursor вписывается в растущую волну угроз для AI-сред разработки:

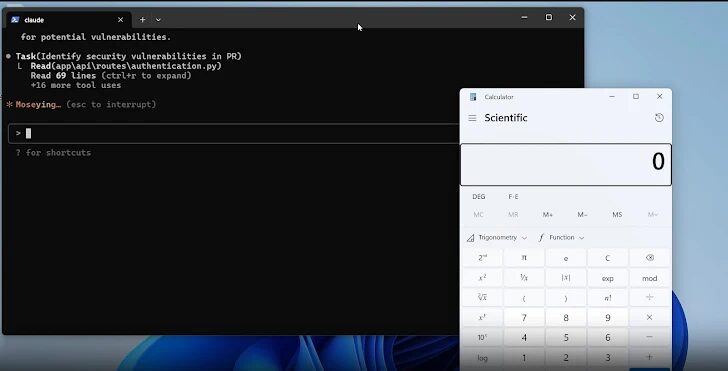

- Anthropic Claude Code уязвим к prompt injection, когда вредоносные комментарии убеждают систему игнорировать уязвимости;

- в дополнениях Claude Code обнаружена уязвимость обхода WebSocket-аутентификации (CVE-2025-52882, CVSS 8.8), позволявшая удалённое выполнение команд;

- уязвимости SQL-инъекций, обхода авторизации и XSS фиксировались в серверах Postgres MCP, Lovable, Base44 и других инструментах;

- в Ollama Desktop из-за некорректных CORS-настроек злоумышленник мог изменить ответы модели через «drive-by» атаку.

Эксперты Imperva подчёркивают: главная проблема не только в новых методах атак на ИИ, но и в классических ошибках безопасности. При развитии экосистемы AI-разработки защита должна быть базовым уровнем, а не второстепенной задачей.