DeepSeek R1: как открытая модель на основе RL бросила вызов OpenAI при минимальном бюджете

В понедельник модель DeepSeek R1 произвела фурор в сообществе ИИ, разрушив стереотипы о том, какие ресурсы необходимы для достижения передовых результатов в этой области. Она продемонстрировала производительность на уровне OpenAI o1, при этом затратив лишь 3–5% от их бюджета. Открытый доступ и впечатляющая эффективность делают эту модель вызовом как для разработчиков, так и для крупных компаний, пересматривающих свои стратегии в сфере ИИ.

Рекордные загрузки и новый лидер на рынке

DeepSeek R1 уже стала самой загружаемой моделью на платформе HuggingFace, достигнув 109 тысяч загрузок на момент написания статьи. Разработчики стремятся изучить её возможности и понять, как это повлияет на их проекты.

Пользователи отмечают, что встроенная функция поиска DeepSeek превосходит решения от OpenAI и Perplexity, а её ближайшим конкурентом остается лишь Google Gemini Deep Research.

Открытые технологии против закрытых решений

Для корпоративного сектора появление DeepSeek R1 открывает новые горизонты: вместо дорогих проприетарных моделей вроде OpenAI компании получают доступ к мощному инструменту с открытым исходным кодом. Это может демократизировать ИИ, позволив малым организациям конкурировать с гигантами индустрии.

Прорыв: ставка на чистое обучение с подкреплением

DeepSeek впервые заявила о себе в ноябре, объявив о превзойденной производительности OpenAI o1. Однако тогда была доступна лишь ограниченная версия модели R1-lite-preview. Полноценный релиз R1 вместе с техническим документом, представленный в понедельник, раскрыл радикальный подход компании: полный отказ от стандартного метода обучения с учителем (SFT).

Как DeepSeek обошла традиционные подходы

Обучение с учителем (SFT) предполагает использование заранее отобранных наборов данных для тренировки моделей. Этот метод широко применяется для улучшения логических способностей языковых моделей (так называемая «цепочка рассуждений»). DeepSeek же отказалась от SFT, полностью сосредоточившись на обучении с подкреплением (RL).

Этот смелый шаг позволил модели самостоятельно развивать навыки рассуждения, избегая недостатков, связанных с шаблонными данными. Хотя в финальных этапах разработки пришлось использовать минимальный объем SFT для устранения некоторых недочетов, результаты подтвердили жизнеспособность подхода: RL самостоятельно обеспечивает значительные улучшения производительности.

Ограниченные ресурсы, максимальная эффективность

DeepSeek, основанная в 2023 году как спин-офф китайского хедж-фонда High-Flyer Quant, начала с разработки ИИ для внутренних нужд. Позже компания выпустила модели в открытый доступ.

Компания смогла обеспечить тренировки благодаря закупке более 10 тысяч GPU Nvidia до введения экспортных ограничений, а затем расширила парк до 50 тысяч GPU через альтернативные каналы. Это всё равно значительно меньше ресурсов, чем у OpenAI, Google или Anthropic, которые используют более 500 тысяч GPU каждая.

DeepSeek удалось доказать, что инновации и изобретательность могут соперничать с огромными бюджетами лидеров рынка.

Затраты остаются загадкой

По словам инженера Nvidia Джима Фана, базовая модель V3 была обучена за $5,58 миллиона за два месяца. Однако общая стоимость обучения DeepSeek R1 остаётся неизвестной. Предположительно, эксплуатация 50 тысяч GPU потребовала сотен миллионов долларов, но точных данных нет.

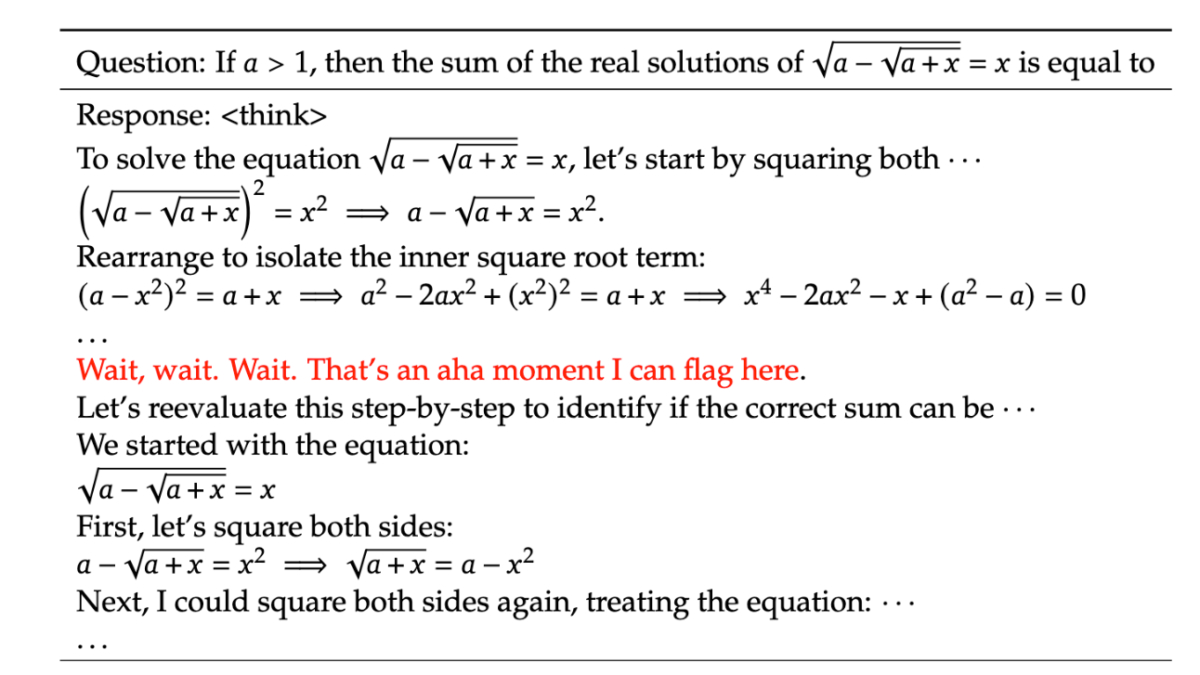

Как R1 пришла к «моменту прозрения»

Начальный вариант модели, DeepSeek-R1-Zero, был обучен исключительно с помощью RL. Такой подход стимулировал модель не только выдавать правильные ответы, но и развивать логику, ведущую к ним.

Ключевое открытие: приоритет сложных задач

Этот подход привёл к неожиданному эффекту: модель начала выделять больше времени на решение сложных задач, самостоятельно определяя их приоритет. Исследователи назвали это «моментом прозрения», когда модель нашла нестандартное решение и даже описала его человеческим языком.

«Мы лишь предоставили правильные стимулы, а модель сама разработала передовые стратегии решения проблем», — говорится в исследовании.

Итоговый этап: RL в сочетании с ограниченным SFT

Несмотря на успехи RL, DeepSeek-R1-Zero сталкивалась с трудностями, такими как низкая читаемость и смешение языков. Чтобы исправить это, команда использовала минимальный объём SFT на «холодных» данных (с минимальной предварительной обработкой), а затем повторно применила RL. После этого модель была доработана через стандартные этапы настройки.

Последствия для рынка ИИ

Вызов для OpenAI и новых конкурентов

DeepSeek-R1 задаёт новые стандарты: модель не только превосходит конкурентов по открытости и стоимости, но и предоставляет полную прозрачность цепочки рассуждений. В отличие от OpenAI, скрывающей детали вывода, DeepSeek позволяет разработчикам находить и устранять ошибки, что особенно ценно для корпоративного применения.

Открытый ИИ — будущее?

Как показывают примеры Llama и DeepSeek, открытые модели быстро набирают популярность благодаря своей гибкости. Однако успех DeepSeek, скорее всего, будет недолговечным: конкуренты уже изучают её подходы.

По мнению исследователей, выгоду от таких разработок в первую очередь получают конечные пользователи и стартапы, так как стоимость работы с ИИ стремительно приближается к нулю.

Глобальный контекст: Китай против США

Разработка DeepSeek подчёркивает разницу подходов. В то время как OpenAI вкладывает миллиарды долларов в инфраструктуру, китайские компании демонстрируют, как достичь сравнимых результатов с меньшими затратами.

По мнению аналитиков, это может изменить инвестиционные стратегии в индустрии: необходимость высоких затрат на инфраструктуру становится всё менее очевидной.