Для людей легко понять, как объект будет чувствовать себя, глядя на него, или сказать, как выглядит объект, касаясь его, но это может быть большой проблемой для машин. Теперь новый робот, разработанный Лабораторией информатики и искусственного интеллекта MIT (CSAIL), пытается это сделать.

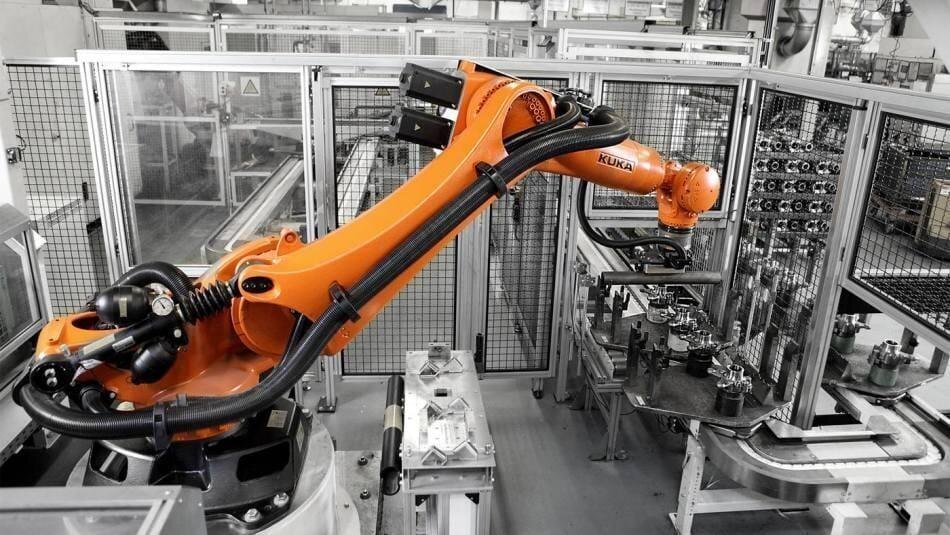

Команда взяла руку робота KUKA и добавила тактильный датчик GelSight, созданный группой Теда Адельсона в CSAIL. Информация, собранная GelSight, затем была передана в ИИ, чтобы он мог изучить связь между визуальной и тактильной информацией.

Чтобы научить ИИ распознавать объекты на ощупь, команда записала 12 000 видеороликов с 200 объектами, такими как ткани, инструменты и предметы быта, к которым прикасались. Видео были разбиты на неподвижные изображения, и AI использовал этот набор данных для соединения тактильных и визуальных данных.

«Глядя на сцену, наша модель может вообразить ощущение прикосновения к плоской поверхности или к острому краю», — говорит Юньчжу Ли, аспирант CSAIL и ведущий автор новой статьи о системе. «Слепое касание нашей модели может предсказать взаимодействие с окружающей средой исключительно по тактильным ощущениям. Объединение этих двух чувств может расширить возможности робота и сократить объем данных, которые могут нам понадобиться для выполнения задач, связанных с манипулированием и захватом объектов».

На данный момент робот может идентифицировать объекты только в контролируемой среде. Следующим шагом является создание большего набора данных, чтобы робот мог работать в более разнообразных условиях.

Подобные методы потенциально могут быть очень полезны для робототехники, когда вам нужно ответить на вопросы типа» Этот объект твердый или мягкий? «Или» Если я подниму эту кружку за ручку, насколько хороша моя хватка? » «говорит Эндрю Оуэнс, исследователь докторской диссертации в Калифорнийском университете в Беркли. «Это очень сложная проблема, так как сигналы очень разные, и эта модель продемонстрировала большие возможности.