Xiaomi представила MiMo-V2-Flash — высокоскоростную open-source ИИ-модель нового поколения

Xiaomi представила свою самую продвинутую на сегодняшний день открытую большую языковую модель под названием MiMo-V2-Flash. Разработка стала частью активного продвижения компании в сфере фундаментального искусственного интеллекта. Новая модель делает упор на высокую скорость работы, эффективную архитектуру и сильные возможности в логическом мышлении и генерации кода.

В Xiaomi позиционируют MiMo-V2-Flash как прямого конкурента таких моделей, как DeepSeek V3.2 и Claude 4.5 Sonnet.

MiMo-V2-Flash построена по архитектуре Mixture-of-Experts и насчитывает 309 миллиардов параметров, из которых 15 миллиардов активны во время выполнения. Модель специально оптимизирована для сценариев с ИИ-агентами и многошаговых диалогов, где требуется быстрая инференция.

В основе лежит гибридная схема внимания 1:5, сочетающая глобальное внимание и Sliding Window Attention с окном в 128 токенов. Нативная длина контекста составляет 32 000 токенов, при этом обучение велось с поддержкой контекста до 256 000 токенов. Такая конструкция позволяет эффективно обрабатывать длинные запросы без существенного роста затрат. По заявлению Xiaomi, модель работает быстрее ряда конкурентов, включая DeepSeek и Claude, при более низкой стоимости эксплуатации.

Согласно результатам бенчмарков, MiMo-V2-Flash входит в число лучших open-source моделей в задачах логического мышления и занимает топ-2 в тестах AIME 2025 и GPQA-Diamond. В инженерных и программных тестах, таких как SWE-Bench Verified и SWE-Bench Multilingual, модель превосходит другие открытые решения и демонстрирует уровень, сопоставимый с GPT-5 и Claude 4.5 Sonnet.

Стоимость использования API установлена на уровне 0,1 доллара за миллион входных токенов и 0,3 доллара за миллион выходных токенов. В настоящее время доступ к API предоставляется бесплатно в течение ограниченного времени. Скорость генерации достигает 150 токенов в секунду, при этом затраты на инференцию, по данным компании, составляют всего около 2,5 процента от стоимости Claude.

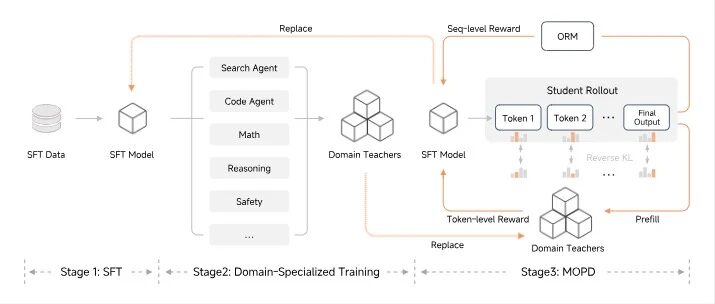

Одной из ключевых технологий стала поддержка Multi-Token Prediction, позволяющая модели генерировать сразу несколько токенов параллельно с последующей проверкой. Это повышает скорость декодирования в 2-2,6 раза без увеличения нагрузки на память и механизм внимания. Также Xiaomi внедрила метод постобучения Multi-Teacher Online Policy Distillation, при котором несколько моделей-учителей направляют обучение через поуровневые вознаграждения. Такой подход позволяет добиться высокой эффективности, используя менее одной пятидесятой ресурсов по сравнению с традиционными RL-подходами, а также поддерживает непрерывное самообучение.

Для пользователей и разработчиков запущен веб-интерфейс MiMo Studio, который позволяет напрямую взаимодействовать с моделью. Сервис поддерживает веб-поиск, агентные сценарии, генерацию кода и переключение между быстрыми ответами и более медленным режимом глубокого рассуждения. Модель способна создавать рабочие HTML-страницы и хорошо интегрируется с инструментами разработки, такими как Claude Code и Cursor.

MiMo-V2-Flash полностью распространяется как open-source-проект под лицензией MIT. Веса модели опубликованы на Hugging Face, а код инференции доступен на GitHub. В день запуска Xiaomi также внесла вклад в проект SGLang, рассчитывая ускорить распространение и внедрение модели среди разработчиков.

В целом MiMo-V2-Flash отражает стремление Xiaomi закрепиться в качестве серьёзного игрока на рынке искусственного интеллекта, предлагая сочетание высокой производительности, низкой стоимости и открытости для сообщества.