Учёные выяснили, почему LLM «рассуждают» неправильно

Исследование учёных из Университета штата Аризона (ASU) поставило под сомнение надежность популярного подхода Chain-of-Thought (CoT) в больших языковых моделях (LLM). По мнению авторов, CoT скорее имитирует логическое мышление, чем действительно использует его, опираясь на шаблоны из обучающих данных. Работа предлагает разработчикам практические рекомендации по оценке и улучшению ИИ-систем, а также новую методологию анализа слабых мест LLM.

Chain-of-Thought: обещания и ограничения

Метод CoT-подсказок, в котором ИИ «рассуждает шаг за шагом», получил широкую известность за высокую точность на сложных задачах. Однако, как показывают новые данные, это «поразительное» поведение моделей — не результат абстрактного мышления, а отточенное воспроизведение знакомых языковых шаблонов.

Ранее уже отмечалось, что LLM чаще полагаются не на логику, а на поверхностные семантические признаки. В результате модели выдают правдоподобные, но ошибочные рассуждения, особенно при столкновении с нестандартными задачами или нерелевантной информацией.

Новый подход: «объектив данных» вместо «мышления»

Авторы исследования предложили рассматривать CoT не как проявление интеллекта, а как форму структурного сопоставления паттернов. Их гипотеза: успех CoT основан не на способности к умозаключениям, а на умении обобщать на задачи, похожие по структуре на обучающие примеры. При этом любая попытка применить CoT вне «области данных», на которых модель обучалась, приводит к резкому падению точности.

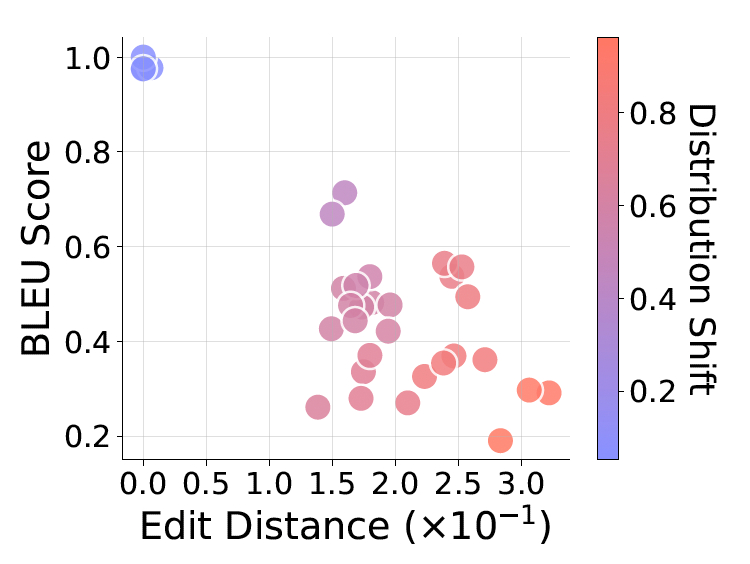

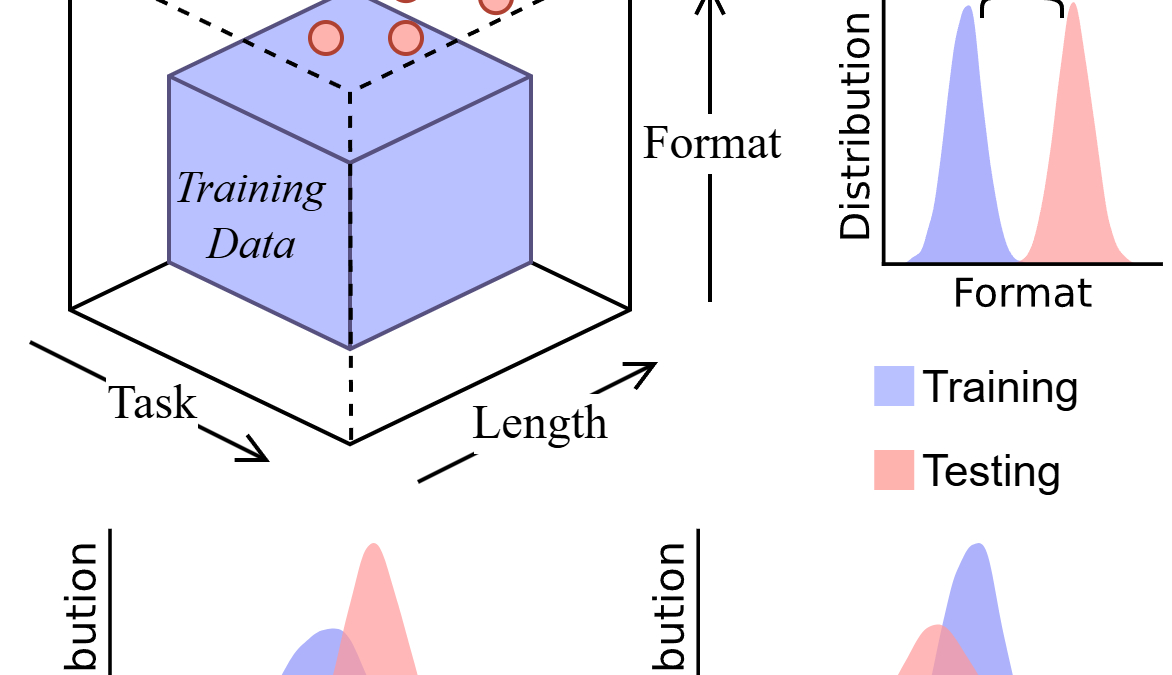

Для проверки этой идеи учёные применили методику анализа по трём видам «распределительного сдвига»:

- Обобщение по задачам: справится ли модель с новым типом заданий?

- Обобщение по длине: выдержит ли она логические цепочки другой длины?

- Обобщение по формату: как скажется изменение формулировок и структуры запроса?

Эксперименты проводились в контролируемой среде с использованием собственной системы DataAlchemy, позволяющей обучать модели с нуля и точно отслеживать, где и как возникают сбои.

«Наша цель — создать пространство для открытого анализа границ возможностей ИИ», — отметил соавтор работы Чэншуай Чжао, аспирант ASU.

Результаты: CoT рушится за пределами обучающего контекста

Авторы пришли к выводу, что рассуждения CoT — это «структурированное сопоставление паттернов», ограниченное статистикой обучающей выборки. Даже минимальный отход от привычной структуры приводит к сбоям:

- На новых типах задач модели просто повторяли похожие по шаблону ответы.

- Изменения длины логической цепочки вызывали попытки «дополнить» или «сократить» шаги до привычного размера.

- Даже небольшие правки в тексте запроса резко снижали точность.

Любопытно, что большинство этих проблем можно частично устранить с помощью точечной дообучаемости (SFT) на небольшом количестве новых примеров. Однако это лишь подтверждает основную гипотезу: модели не «понимают», а «запоминают» новые шаблоны.

Практические выводы для разработчиков ИИ

Исследователи подчёркивают, что CoT не стоит воспринимать как надёжную технологию для критически важных приложений. Они дают три ключевых совета:

- Не переоценивать стабильность CoT. Модели могут выдавать «гладкий абсурд» — логически неверные, но правдоподобные рассуждения. Это опасно в юриспруденции, финансах и других сферах, где ошибка критична. Экспертная верификация обязательна.

- Тестировать вне обучающей зоны. Обычная валидация, где тестовые данные совпадают с обучающими, не выявляет слабые места. Нужно намеренно проверять модели на задачах с искажённой структурой, длиной и формулировкой.

- Не полагаться полностью на дообучение. SFT помогает «заплатками» адаптировать модель к новым данным, но не развивает универсальность. Это расширяет обучающую «пузырь» модели, не выходя за его пределы.

Модели под задачу: точечная настройка вместо универсальности

Авторы подчеркивают: несмотря на ограничения CoT, модели всё ещё могут быть полезны. Большинство бизнес-приложений работают с узкими, хорошо предсказуемыми задачами. Если заранее протестировать поведение модели по конкретным параметрам — типу задач, длине и формату запроса — можно определить границы её «зоны уверенности».

В этом случае дообучение превращается из запоздалой «латки» в инструмент точной настройки. Разработчики могут создавать малые обучающие выборки, покрывающие уязвимости модели, не претендуя на развитие абстрактного мышления. Такой подход позволяет превратить CoT в надёжный механизм сопоставления паттернов под конкретные задачи.