Alibaba выпустила Marco-o1: новая большая языковая модель

Компания Alibaba продолжает задавать тренды в области искусственного интеллекта. Недавно исследователи представили новую языковую модель Marco-o1, которая способна решать сложные и открытые задачи, выходящие за пределы традиционных подходов к обучению. Эта разработка основывается на успехе OpenAI o1 и концепции больших моделей рассуждений (LRM), предлагая улучшенные механизмы обработки данных и принятия решений.

Что делает Marco-o1 уникальной?

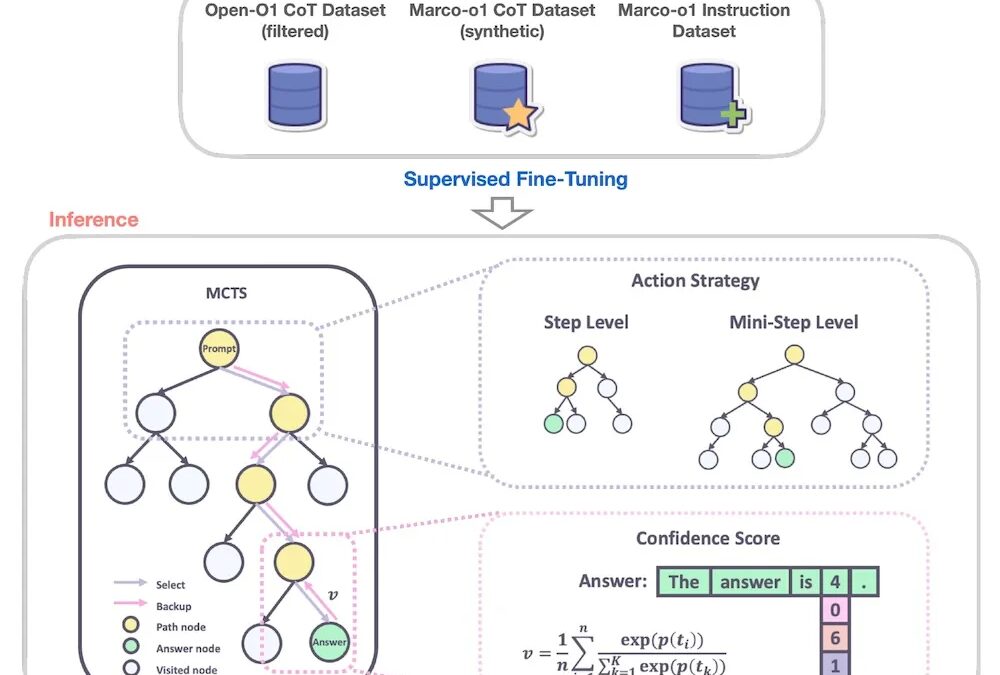

Marco-o1 представляет собой усовершенствованную версию модели Qwen2-7B-Instruct, интегрирующую передовые технологии, такие как метод цепочек размышлений (Chain-of-Thought, CoT), алгоритм Монте-Карло (Monte Carlo Tree Search, MCTS) и инновационные стратегии анализа. Эти методы позволяют модели справляться с задачами, где отсутствуют четкие стандарты или метрики успеха.

Преимущества Monte Carlo Tree Search

MCTS активно применяется в Marco-o1 для моделирования и оценки множества вариантов решений. Этот алгоритм позволяет модели формировать дерево возможных ответов, учитывая уверенность в каждом из вариантов. Благодаря этому подходу Marco-o1 не просто отвечает на вопросы, но также обдумывает несколько возможных решений, выбирая наиболее подходящее.

Исследователи из Alibaba также внедрили возможность настраивать детализацию MCTS. Пользователи могут задавать количество токенов, генерируемых на каждом этапе анализа, что позволяет найти баланс между точностью и затратами на вычисления.

Встроенный механизм самокоррекции

Одна из уникальных особенностей Marco-o1 — это система рефлексии. Во время анализа данных модель периодически напоминает себе о необходимости пересмотра решений с помощью фразы: «Подождите! Возможно, я ошибся. Надо подумать заново». Такой подход помогает исправлять ошибки на ранних стадиях, делая результаты более точными и надежными.

Результаты тестирования: от математики до перевода идиом

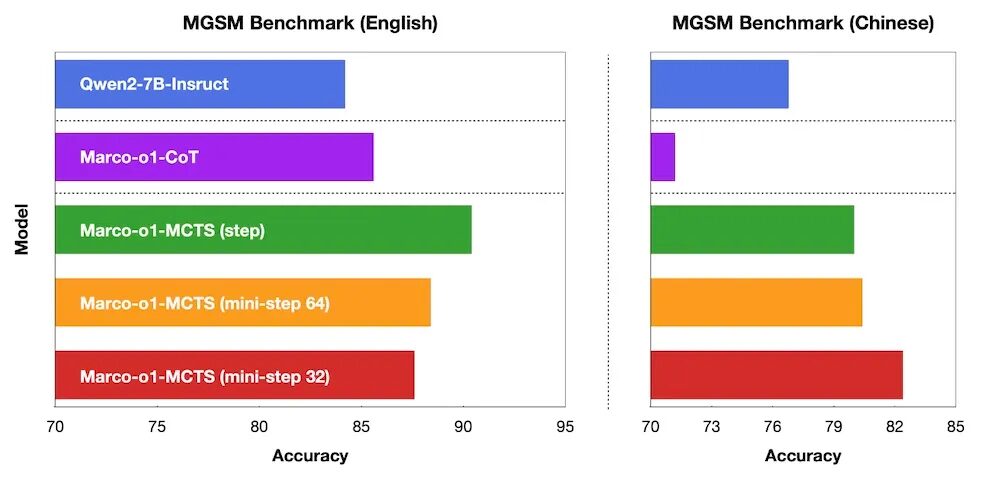

Для проверки возможностей модели исследователи протестировали Marco-o1 на задачах разной сложности. На тесте MGSM, включающем математические задачи для учеников начальной школы, модель показала значительное превосходство над базовой версией Qwen2-7B, особенно при использовании MCTS.

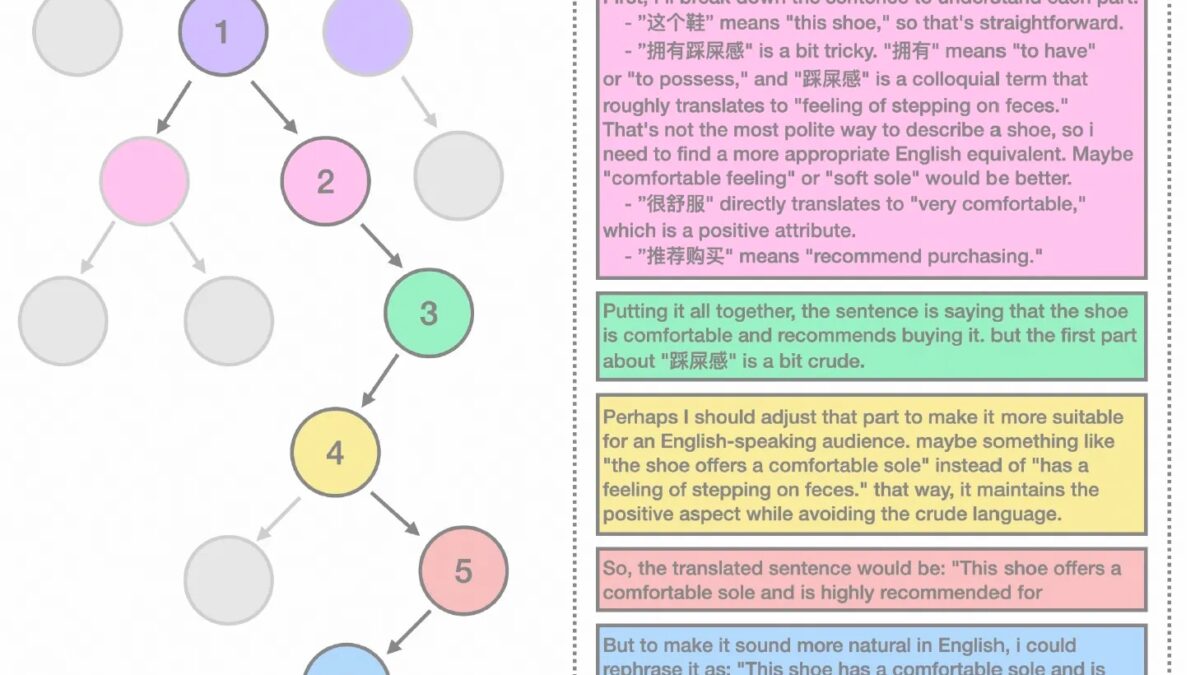

Одной из наиболее впечатляющих функций Marco-o1 стал перевод сложных идиоматических выражений и сленга. Например, модель корректно интерпретировала китайскую фразу «эта обувь дает ощущение наступания на что-то мягкое» как «эта обувь имеет комфортную подошву» на английском языке. Для этого Marco-o1 использовала цепочку размышлений, оценивая культурный и языковой контекст.

Marco-o1 и будущее моделей рассуждений

Marco-o1 уже доступна для исследователей на платформе Hugging Face вместе с частично открытым набором данных. Этот шаг подчеркивает стремление Alibaba поддерживать инновации и развитие в сообществе разработчиков искусственного интеллекта.

Новая эра конкуренции в разработке LRM

Marco-o1 не единственная модель, появившаяся в результате вдохновения OpenAI o1. На прошлой неделе китайская лаборатория DeepSeek представила своего конкурента R1-Lite-Preview, а исследователи из университетов Китая выпустили LLaVA-o1 — модель для обработки изображений и текста с использованием подхода временного масштабирования вывода. Эти модели продолжают развивать идеи, заложенные OpenAI, и демонстрируют, как временное масштабирование может изменить подход к обучению ИИ.