Pruna AI сделала открытым свой фреймворк для сжатия ИИ-моделей

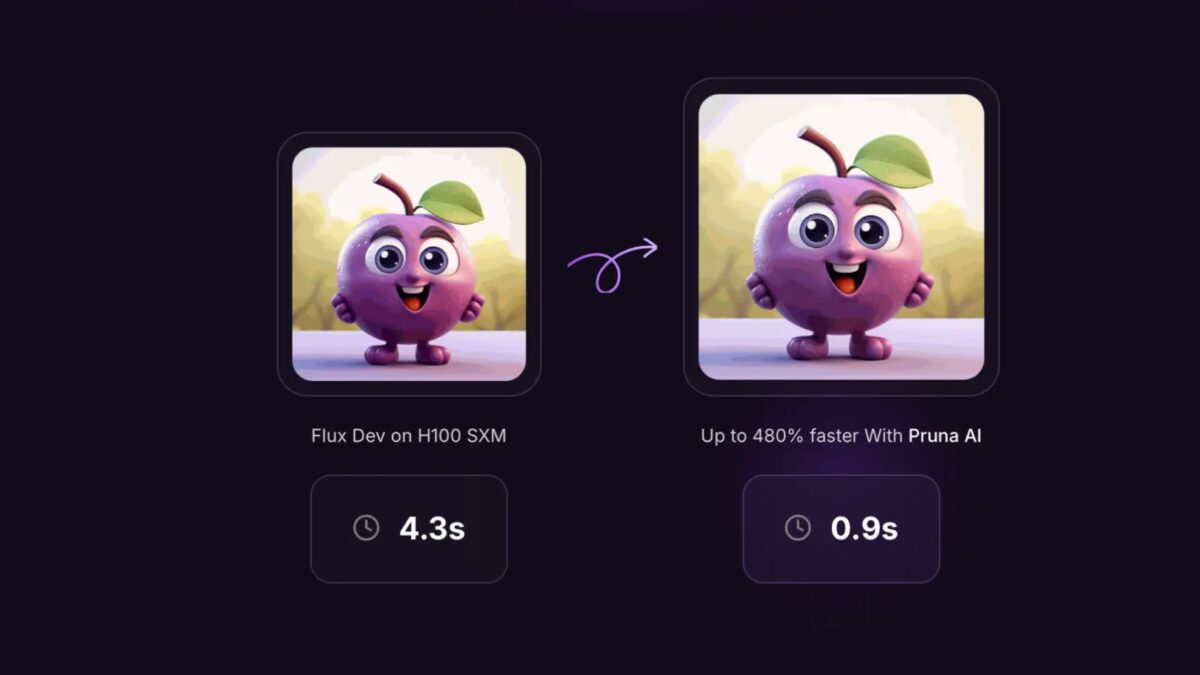

Европейский стартап Pruna AI, разрабатывающий алгоритмы сжатия ИИ-моделей, объявил, что в четверг сделает свой фреймворк с открытым исходным кодом. Этот инструмент позволяет оптимизировать работу нейросетей за счет методов кэширования, обрезки (pruning), квантизации и дистилляции.

Как работает фреймворк Pruna AI?

Фреймворк Pruna AI позволяет разработчикам автоматизировать сжатие моделей, комбинировать различные методы оптимизации и оценивать их влияние на качество модели.

“Если провести аналогию, то мы делаем для методов сжатия то же, что Hugging Face сделал для трансформеров и диффузионных моделей — стандартизируем вызов, сохранение и загрузку,” — объясняет сооснователь и CTO Pruna AI Джон Рачван в интервью TechCrunch.

Почему это важно?

Крупные ИИ-лаборатории, такие как OpenAI, уже используют дистилляцию для ускорения своих моделей. Например, GPT-4 Turbo — это упрощенная и более быстрая версия GPT-4, а модель Flux.1-schnell была создана как дистиллированная версия Flux.1 от Black Forest Labs.

Метод дистилляции позволяет извлекать знания из большой модели с помощью механизма «учитель-ученик». Разработчики отправляют запросы к мощной модели, анализируют ее ответы и обучают более компактную нейросеть, которая приближенно воспроизводит поведение оригинала.

“Обычно большие компании создают такие инструменты внутри своей экосистемы, а в open-source-среде встречаются лишь отдельные методы, такие как квантизация для LLM или кэширование для диффузионных моделей,” — говорит Рачван. — “Pruna AI объединяет их все, делая процесс простым и удобным.”

Кому это пригодится?

Хотя Pruna AI поддерживает различные типы моделей (LLM, диффузионные модели, распознавание речи, компьютерное зрение), основной фокус сейчас — оптимизация генеративных моделей для изображений и видео.

Среди клиентов стартапа уже числятся Scenario и PhotoRoom.

Кроме бесплатной версии, Pruna AI предлагает корпоративное решение с оптимизационным агентом, который автоматически подбирает лучшие параметры компрессии.

“Вы просто загружаете модель и указываете, что хотите увеличить скорость, но не потерять в точности более чем на 2%. Затем агент сам подбирает оптимальную комбинацию методов сжатия,” — объясняет Рачван.

Бизнес-модель и инвестиции

Pruna AI использует почасовую оплату в Pro-версии, аналогично аренде GPU в облачных сервисах.

Разработчики уверены, что оптимизация ИИ-моделей позволяет сократить затраты на вычисления. Например, они смогли уменьшить модель Llama в 8 раз, практически не потеряв в качестве.

Pruna AI недавно привлек $6,5 млн в рамках посевного раунда. Среди инвесторов:

- EQT Ventures,

- Daphni,

- Motier Ventures,

- Kima Ventures.

Фреймворк с открытым исходным кодом станет доступен уже в этот четверг.