Apple показала FastVLM — ИИ-модель, которая может лечь в основу будущих «умных» очков

Apple готовится к выпуску AI-устройств нового поколения, и свежая разработка команды Machine Learning Research может подсказать, каким будет их «ум» под капотом. Речь о FastVLM — визуально-языковой модели, созданной на базе собственного фреймворка MLX, заточенного под Apple Silicon. Эта модель отличается высокой скоростью, компактностью и низкими требованиями к ресурсам, что делает её идеальной для работы прямо на устройстве — без подключения к облаку.

Умные очки и AirPods с камерами: выход в 2027 году?

Слухи о новых носимых гаджетах от Apple — AI-очках и AirPods с камерами — циркулируют уже несколько месяцев. Предполагается, что релиз состоится в 2027 году, и устройства станут прямыми конкурентами Meta* Ray-Ban Smart Glasses. Хотя финальный дизайн пока неизвестен, логика подсказывает: такие гаджеты должны иметь локальные нейросети, способные интерпретировать визуальные данные без задержек.

Что такое FastVLM?

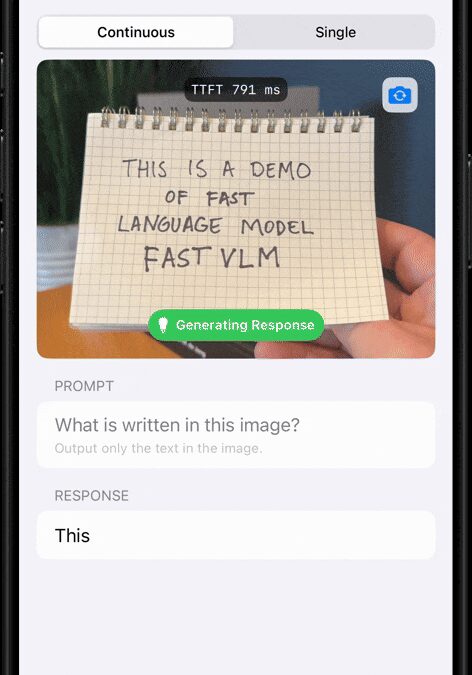

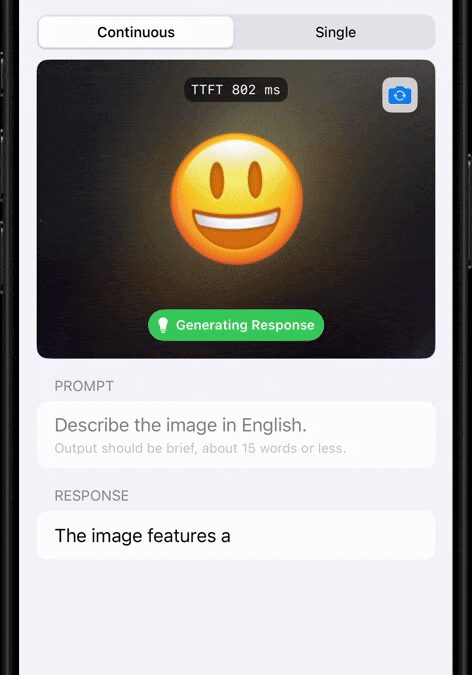

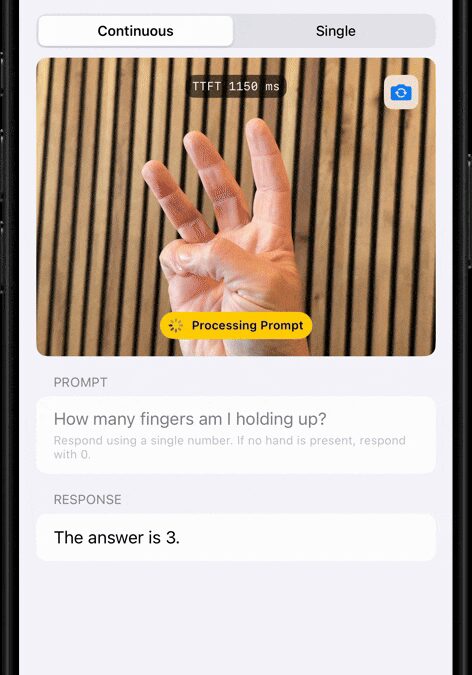

FastVLM (Fast Visual Language Model) — это модель нового поколения, разработанная с учётом специфики Apple Silicon и возможностей фреймворка MLX. Она умеет:

- Распознавать жесты (например, количество пальцев),

- Определять эмоции и эмодзи,

- Читать рукописный текст и символы.

В основе FastVLM лежит энкодер FastViTHD, оптимизированный для работы с изображениями высокого разрешения и минимальной задержкой.

Почему это важно?

- FastVLM работает до 3,2 раза быстрее и в 3,6 раза компактнее аналогичных моделей.

- Время до первого ответа модели (time-to-first-token) — в 85 раз быстрее, чем у конкурентов.

- Модель использует меньше токенов, что снижает нагрузку на систему и ускоряет работу в режиме реального времени.

Это критично для носимых устройств, которым нужно моментально обрабатывать визуальные данные без подключения к облаку — будь то считывание объектов, текста или реакция на жесты пользователя.

MLX — ключ к ИИ на устройствах Apple

В 2023 году Apple представила MLX — фреймворк с открытым исходным кодом, оптимизированный для локального обучения и выполнения моделей на чипах Apple. Его синтаксис близок к привычным AI-инструментам, но при этом он более лёгкий и энергоэффективный — как раз то, что нужно для автономных гаджетов.

Где можно посмотреть?

- Код FastVLM опубликован на GitHub — желающие могут протестировать или интегрировать модель.

- На arXiv доступен технический отчёт, в котором подробно описана архитектура модели и методика оптимизации.

* Принадлежит компании Meta, она признана экстремистской организацией в РФ и её деятельность запрещена.