В России появилась платформа для оценки генеративных нейросетей

В России появилась первая независимая платформа на русском языке для оценки качества больших языковых моделей на основе пользовательских задач – LLM Arena. Ее создал Роман Куцев в коллаборации с экспертами по нейросетям и бывшими разработчиками TrainingData.ru. Рейтинг показывает, как генеративные нейросети справляются с реальными задачами пользователей – это один из самых популярных способов оценки качества ответов в мире.

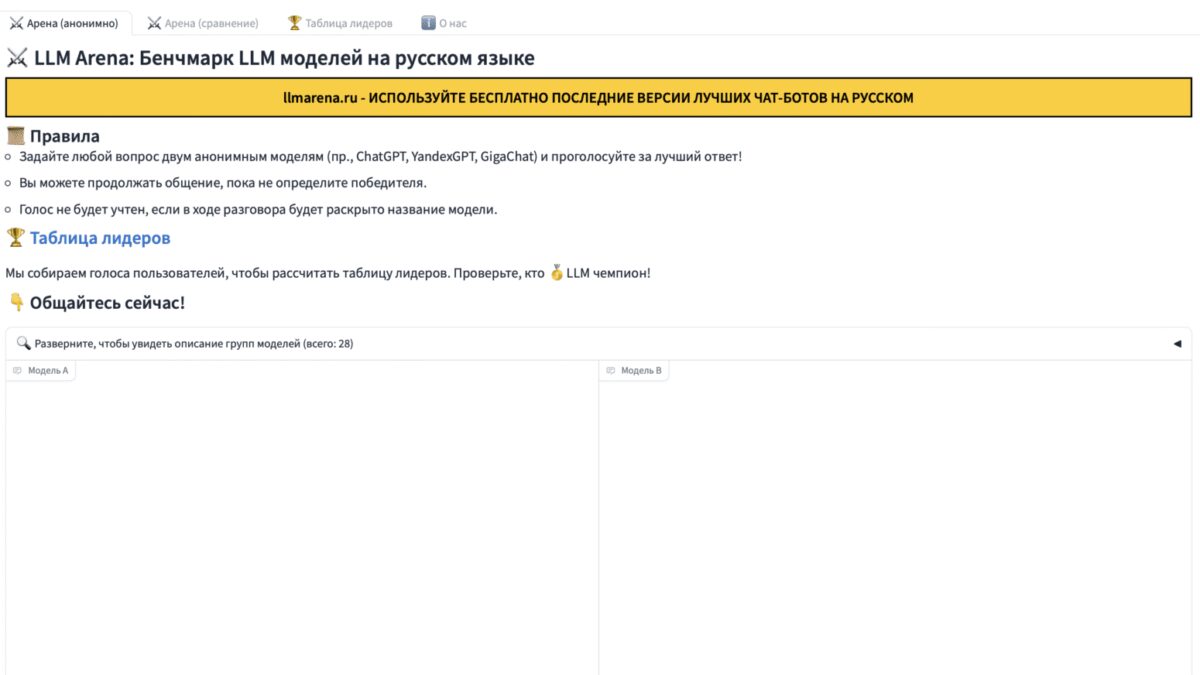

Платформа позволяет в режиме реального времени тестировать русскоязычные нейросети и оценивать качество их ответов в соответствии с запросом. Для сравнения пользователю предлагаются две случайные модели — при оценке он не будет знать, кем разработаны нейросети. Можно написать любой запрос, сравнить ответы моделей и выбрать тот, который пользователь посчитает лучшим (например, если он содержит больше фактов или является более развернутым и подкрепленным примерами и т.д.). Если ответы нерелевантные или похожие, это также можно отметить. На основе полученных оценок формируется рейтинг генеративных нейросетей на русском языке.

Сейчас пользователям платформы доступны для тестирования 21 наиболее популярная генеративная нейросеть, среди которых как иностранные модели (ChatGPT, LLaMa), так и российские (YandexGPT, GigaChat, Saiga). Список доступных нейросетей регулярно пополняется: новые модели смогут добавить и их разработчики.

«Наша цель — создать объективный, открытый и актуальный рейтинг языковых моделей на русском языке. Даже несмотря на то, что в мире появляется все больше бенчмарков, позволяющих сравнивать модели, протестировать российские LLM на родном языке на реальных пользовательских задачах очень сложно. Та же LMSYS Chatbot Arena не предоставляет доступ ни к одной российской нейросети. Поэтому нам и пришла в голову идея создать собственную платформу, чтобы пользователи могли сами сравнивать российские и иностранные генеративные нейросети и делать собственные выводы».

Роман Куцев, основатель LLM Arena, выпускник ВМК МГУ, бывший СТО TrainingData.ru

В ближайшее время на платформе появятся новые возможности, которые позволят оценивать качество ответов по разным категориям запросов, например, написание кода, решение сложных вопросов или поддержка длинного контекста беседы. В перспективе можно будет сравнивать ответы нейросетей по мультимодальным задачам. Например, оценить, насколько хорошо модель понимает, что на картинке, или справляется с генерацией видео по тексту.

Отечественный бенчмарк качества генеративных нейросетей создан по открытой лицензии и работает по принципу одного из самых популярных рейтингов LMSYS Chatbot Arena.