Apple раскрыла простой трюк, который делает ИИ умнее на 8%

Учёные из Apple представили исследование, показавшее, что большие языковые модели (LLM) могут значительно повысить точность выполнения заданий, если использовать старый и проверенный инструмент — чек-листы.

Контекст: как обычно обучают языковые модели

После обучения LLM проходит этап донастройки с помощью метода Reinforcement Learning from Human Feedback (RLHF). На этом этапе люди-ассессоры оценивают ответы модели: «лайк» усиливает вероятность похожего ответа в будущем, «дизлайк» — снижает. Такой подход помогает сделать ответы полезнее и безопаснее.

Однако у RLHF есть слабые места. Модель может научиться выдавать «правильные на вид» ответы, которые на самом деле не решают задачу, лишь создавая иллюзию правильности.

Что предложили исследователи Apple

В статье “Checklists Are Better Than Reward Models For Aligning Language Models” компания предложила новый метод — Reinforcement Learning from Checklist Feedback (RLCF).

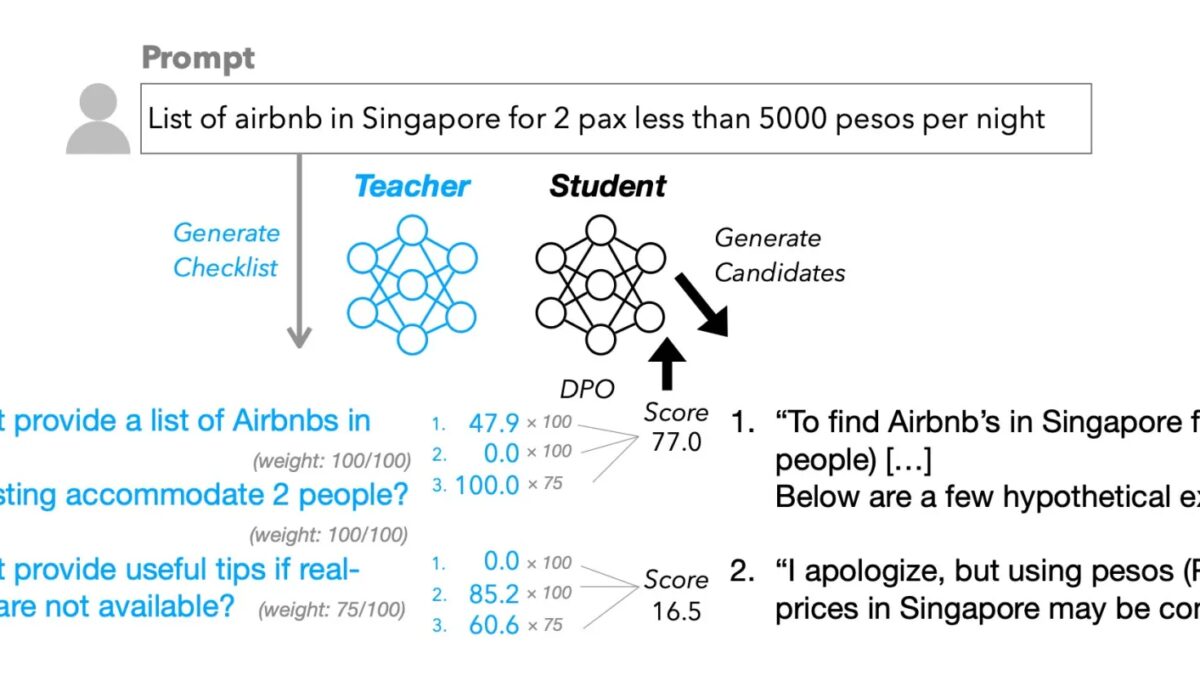

Он работает так:

- Вместо общей оценки «нравится/не нравится» ответы модели проверяются по списку конкретных пунктов («Переведено ли на испанский?», «Есть ли форматирование?» и т. п.).

- Каждый пункт оценивается по шкале от 0 до 100.

- Более мощная модель («учитель») проверяет ответы и выставляет баллы, которые становятся сигналом для дообучения основной («студентской») модели.

Apple даже создала датасет WildChecklists с 130 000 инструкций и автоматически сгенерированными чек-листами.

Результаты исследования

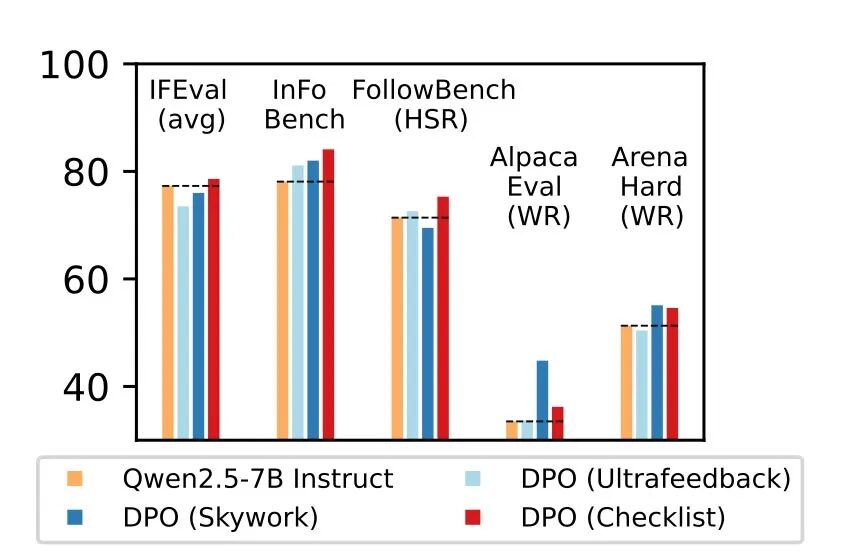

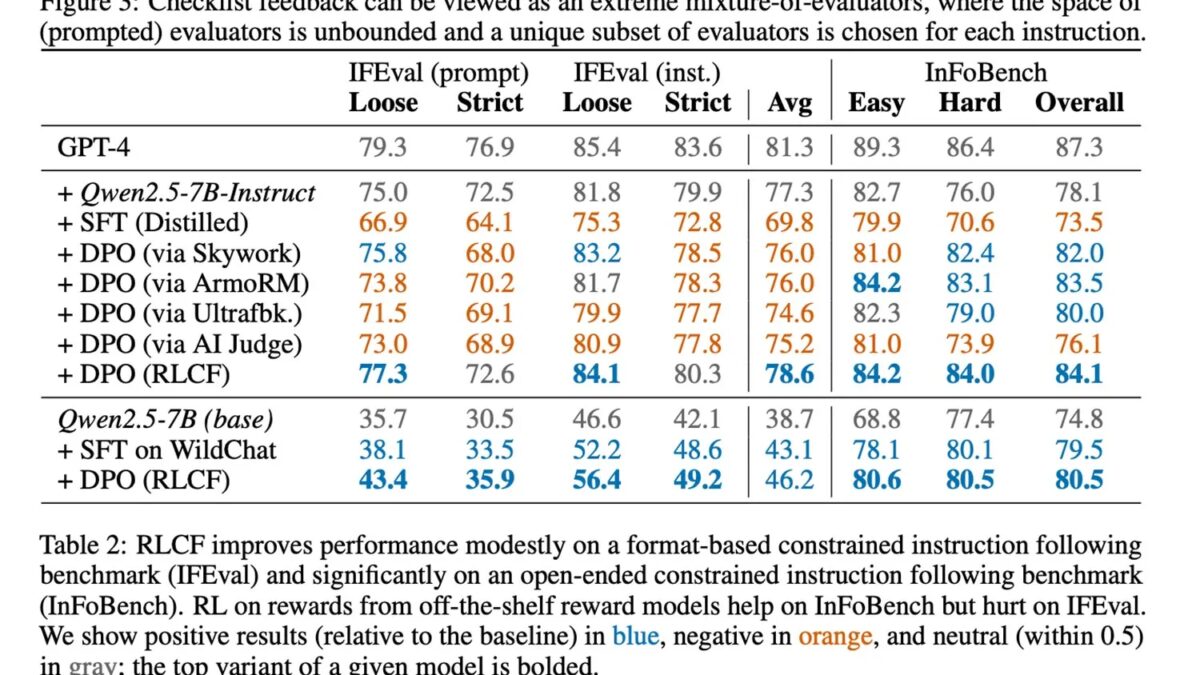

Используя метод RLCF, исследователи протестировали модель Qwen2.5-7B-Instruct на пяти популярных бенчмарках. Результаты показали стабильное улучшение по всем метрикам:

- +4 пункта в FollowBench,

- +6 пунктов в InFoBench,

- +3 пункта в Arena-Hard.

В отдельных тестах улучшение достигало 8,2%. Это делает чек-листы более эффективным методом, чем классические reward-модели.

Ограничения подхода

- Метод фокусируется на сложных многошаговых инструкциях, но может быть менее полезен в других сценариях.

- Для проверки требуется более мощная модель, что делает процесс ресурсоёмким.

- Важно: RLCF улучшает следование инструкциям, но не решает проблему безопасности моделей.

Почему это важно

Авторы подчёркивают: с ростом популярности LLM в роли персональных ассистентов пользователи ждут, что модели будут строго и точно выполнять сложные пошаговые задания. В будущем, когда такие ассистенты получат больше автономии, точность следования инструкциям станет ключевым фактором их полезности.