Apple представила исследовательский датасет Pico-Banana-400K для обучения AI-редакторов изображений

Apple выпустила Pico-Banana-400K — тщательно отобранный набор из 400 тысяч изображений, предназначенный для обучения моделей текстового редактирования. Любопытно, что при создании Apple использовала ИИ Google Gemini-2.5. Датасет распространяется по некоммерческой лицензии и доступен всем исследователям.

Apple объединяет усилия с Google

Исследовательская группа Apple опубликовала работу «Pico-Banana-400K: A Large-Scale Dataset for Text-Guided Image Editing» и открыла созданный набор изображений под лицензией, разрешающей некоммерческое использование. Любой исследователь может скачать его для академической работы или тестирования моделей машинного обучения. Коммерческое применение исключено.

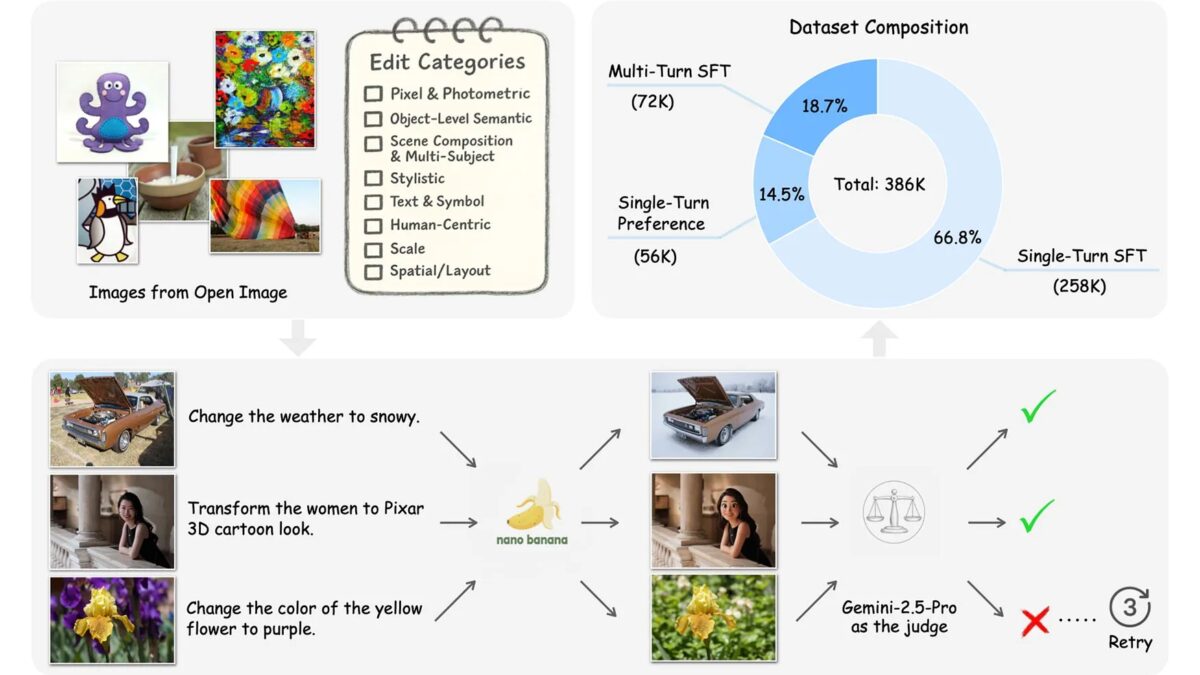

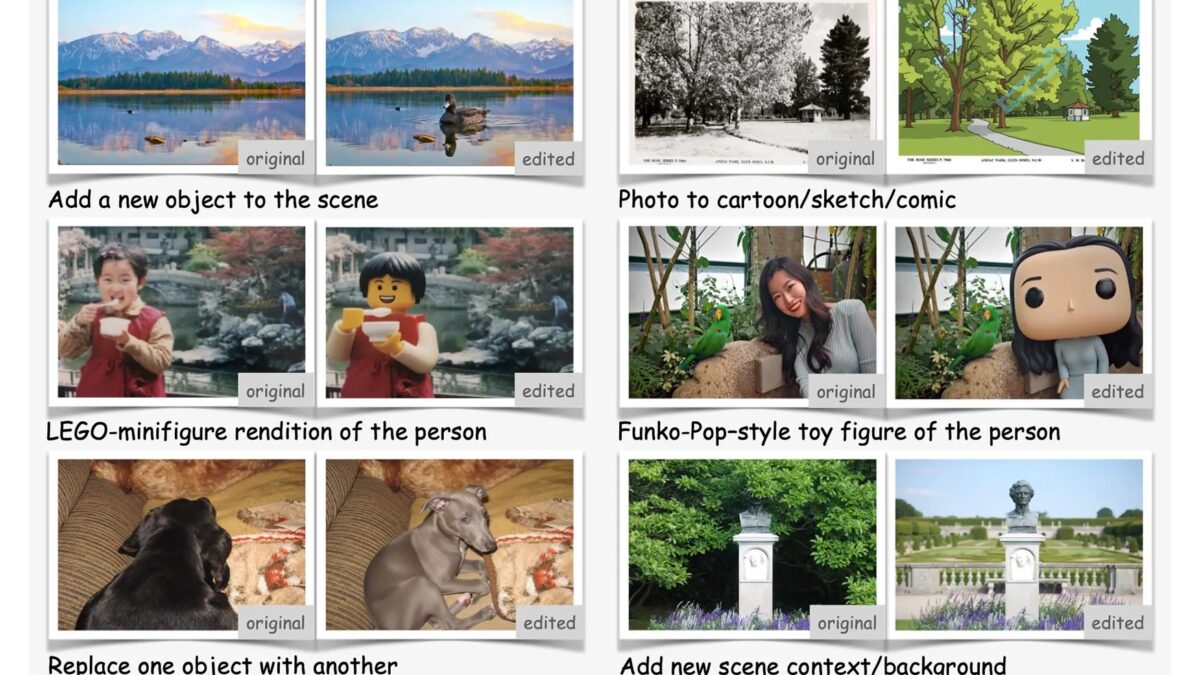

Основой послужил открытый набор OpenImages, из которого Apple отобрала фотографии с людьми, предметами и текстовыми сценами. Далее исследователи определили 35 типов редактирования, сгруппированных в восемь категорий — от цветовых фильтров до сложных пространственных изменений.

Примеры категорий и запросов:

- Pixel & Photometric — добавить плёночное зерно или винтажный фильтр;

- Human-Centric — превратить человека в фигурку Funko Pop;

- Scene Composition & Multi-Subject — изменить погоду (солнечно, дождливо, снежно);

- Object-Level Semantic — переместить объект в кадре;

- Scale — увеличить масштаб.

Как создавался Pico-Banana-400K

Для обработки изображений Apple задействовала модель Gemini-2.5-Flash-Image, известную под кодовым именемNano-Banana. Эта система выполняла текстовые инструкции и генерировала изменённые изображения. После этого результаты проверялись более продвинутой моделью Gemini-2.5-Pro, которая анализировала качество и соответствие исходным запросам. Только одобренные варианты попадали в финальный набор.

Итогом стал датасет, включающий три типа данных:

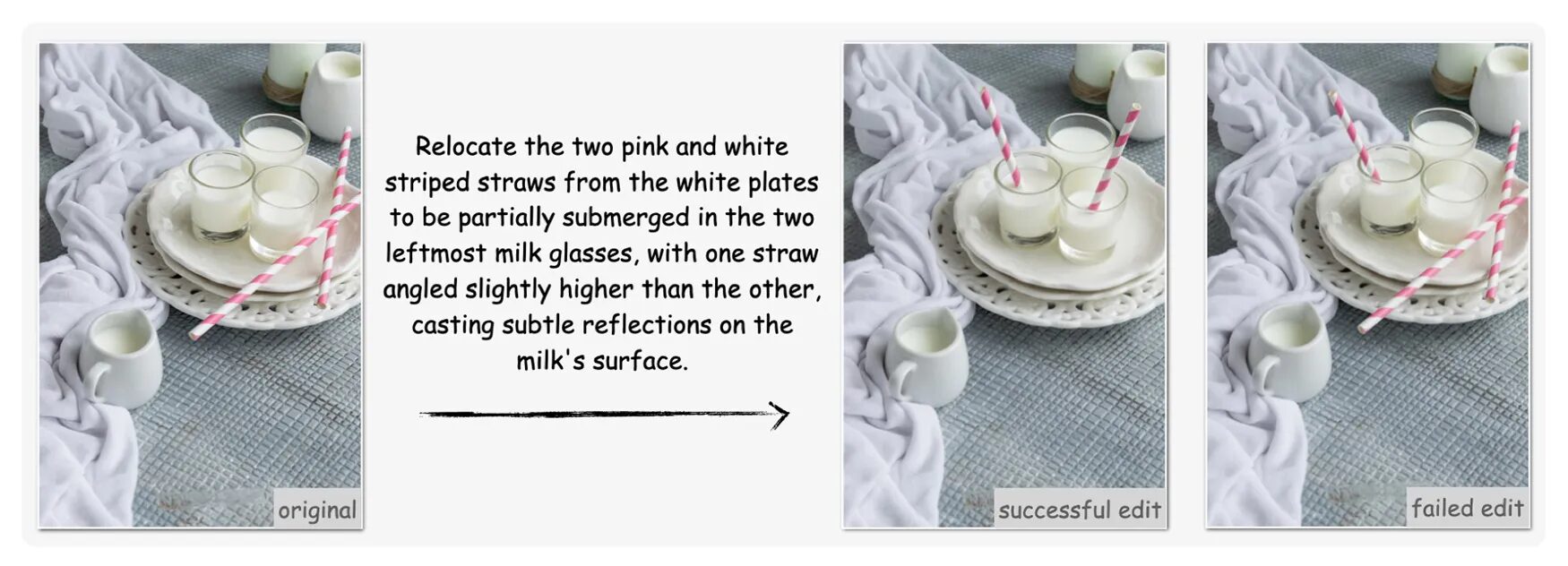

- single-turn edits — одиночные правки по одному запросу;

- multi-turn sequences — последовательности из нескольких итераций редактирования;

- preference pairs — пары изображений, где одно считается успешным, а другое неудачным.

Такая структура позволяет моделям не только учиться корректно редактировать изображения по текстовым подсказкам, но и понимать, что считать ошибкой.

В описании проекта исследователи подчёркивают, что даже передовые модели, включая Nano-Banana, пока ограничены в точном управлении композицией, масштабом и типографикой. Тем не менее, по словам Apple, Pico-Banana-400K создавался как «надёжная основа для обучения и оценки следующего поколения моделей текстового редактирования изображений«.

Почему это важно

Рынок генеративных моделей стремительно растёт, но открытых и качественно аннотированных наборов данных для обучения почти нет. Многие существующие датасеты состоят из синтетических изображений, созданных закрытыми моделями, или слишком малых вручную отобранных выборок.

Apple указывает, что такие ограничения вызывают «смещение доменов, несбалансированное распределение типов правок и нестабильное качество данных, что мешает развитию устойчивых моделей редактирования». Pico-Banana-400K должен устранить эти проблемы.

Исследование опубликовано на arXiv, а сам набор изображений размещён в открытом доступе на GitHub.