Samsung готова запустить массовое производство чипов памяти HBM4 в феврале 2026 года после прохождения финальной стадии квалификации Nvidia — новые чипы лишены проблем с производительностью, которые были у HBM3 и HBM3E.

Чипы HBM3 и HBM3E от Samsung, используемые в AI-ускорителях, столкнулись с проблемами производительности. Компании пришлось переработать HBM3E в прошлом году, чтобы получить одобрение Nvidia. Даже после доработки эти чипы использовались только в отдельных AI-ускорителях Nvidia, продаваемых в Китае.

Теперь Samsung находится в более сильной позиции, поскольку её чипы HBM4 близки к получению одобрения Nvidia. Согласно Bloomberg, чипы памяти HBM4 от Samsung проходят заключительный этап квалификации. Они были отправлены Nvidia в сентябре 2025 года. После запуска массового производства Samsung будет готова поставлять HBM4 не только Nvidia, но и другим производителям AI-ускорителей, включая AMD и Google.

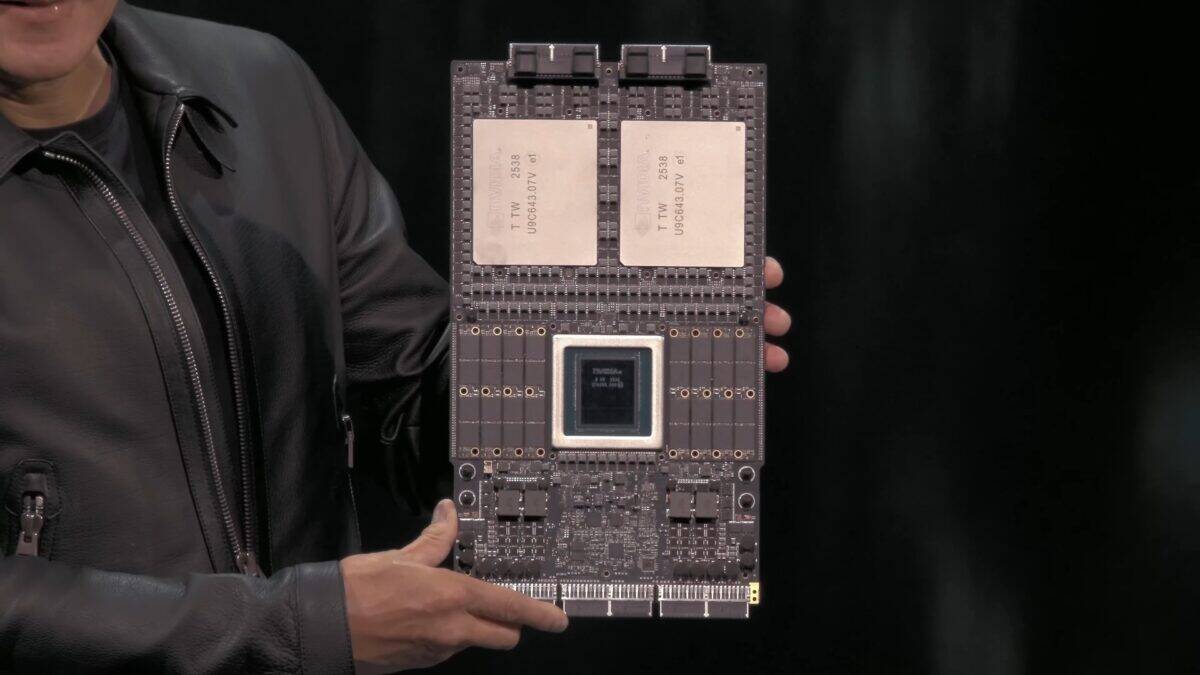

HBM расшифровывается как High-Bandwidth Memory — высокопропускная память. Эта технология использует несколько чипов DRAM, уложенных вертикально, что обеспечивает значительно более высокую пропускную способность и скорость по сравнению с обычной памятью DDR или LPDDR, используемой в смартфонах, компьютерах, серверах и других электронных устройствах. Производство чипов HBM крайне сложное и дорогостоящее.

Несмотря на статус крупнейшего производителя чипов памяти на протяжении десятилетий, Samsung не уделяла достаточного внимания HBM на ранних этапах. Это позволило конкурентам вроде SK Hynix и Micron занять лидирующие позиции на рынке HBM. Когда Samsung усилила фокус на четвёртом поколении HBM (HBM3) и пятом поколении (HBM3E), компания уже отстала от соперников.

Samsung интенсифицировала усилия при разработке чипов шестого поколения HBM (HBM4). Некоторые источники утверждают, что HBM4 от Samsung превосходят конкурирующие чипы памяти SK Hynix и Micron. Ожидается, что эти чипы будут использоваться в флагманском AI-процессоре следующего поколения от Nvidia — Rubin, который выйдет в этом году.